Die Darmstadt Konferenz (Blogbeitrag dazu kommt noch) hat mir wieder einmal gezeigt, wie wenig Soziale Arbeit in Diskursen um Digitalisierungsphänomene involviert ist: Lediglich in einem Vortrag (wenn ich nicht falsch liege) war sie explizit erwähnt.

Im Zentrum der Konferenz um die Digitalstadt Darmstadt standen dabei alle Bereiche der Daseinsfürsorge. Besonders prominent wurde der Einsatz von Künstlicher Intelligenz in ganz unterschiedlichen Kontexten verhandelt, von der vorherschauenden Verkehrssteuerung über selbstfahrende Straßenbahnen bis hin zum integrierten, smarten Quartiersmanagement a la Sidewalk.

Im Nachgang gab es dann aber doch viele Gespräche mit sozialpädagogischen Kolleg*innen und Studierenden, was denn von dem ganzen „Hype“ um Big Data, KI und Co. für die Soziale Arbeit zu halten sei. An einem prominenten Beispiel, nämlich dem Kinderschutz und der damit einhergehenden Frage der Einschätzung von Kindeswohlgefährdung, lassen sich einige Digitalisierungsphänomene für die Soziale Arbeit besonders deutlich zeigen. Das liegt an zwei Dingen: Zum einen wird nirgends in der Sozialen Arbeit so deutlich, wie widersprüchlich und komplex ihre Aufgaben sind wie im Kinderschutz – es geht in der Abklärung von Kindeswohlgefährdung um nichts anderes wie die Sicherung der körperlichen und seelischen Integrität von Kindern mit allen dazugehörigen Diagnostik-, Beratungs- und Interventionsverfahren bis hin zur Herausnahme von Kindern aus der Familie. Also um Entscheidungen, die unter Risiko, meist aber unter Unsicherheit stattfinden. Dies schließt einfache Entscheidungsfindungen per se aus.

Zum anderen lässt sich ein international sehr unterschiedlicher Umgang mit Fragen der (digitalen) Unterstützung bei der Gefährdungseinschätzung beobachten. Er lässt sich auf die Frage zuspitzen, ob und wie Computer überhaupt bei dieser Aufgabe helfen können und sollen und was sie an „Wissen“ dazu beitragen.

Prinzipiell sind zunächst alle Fachkräfte, die mit Kindern und Jugendlichen arbeiten aufgefordert, sensibel auf mögliche Kindeswohlgefährdungssituationen zu reagieren. Kommen sie nicht weiter, treten besondere Fachkräfte hinzu, die „insoweit erfahrenen Fachkräfte“. Die Funktionalität ihres Wissens wird dabei weniger auf einen spezifischen Grundberuf zurück geführt, sondern an einer Kombination aus beruflicher Erfahrung, spezifischer Weiterbildung und ausgewiesener Handlungskompetenz festgemacht. Die hier geleistete Abklärung selbst und die daraus folgende Gefährdungseinschätzung ist dabei nicht einheitlich und strikt definiert. Und genau hier wird es spannend zu überlegen, ob und wie der Computer helfen kann, soll und darf.

Entscheidungsprozesse beruhen dabei derzeit auf vier Optionen, die auf jeweils sehr unterschiedliche Arten Entscheidungen theoretisch und normativ rahmen.

- klinische Urteile

- standardisierte Instrumente, die mehr oder weniger konsensuell gefundene Standards aus der Fachcommunity festlegen

- festgelegte Algorithmen mit definierten Indikatoren, wie sie auch in der Risikostatistik verwendet werden

- KI-getriebene System mit permanenter Mustererkennung („deep learning“, „predictive computing“)

Gemeinhin akzeptiert wird als internationaler Forschungsstand, dass das klinische Urteil alleine am wenigsten verlässlich ist. Häufig werden deshalb standardisierte Instrumente wie die KiWo-Skalen genutzt, die das hoch inferente klinische Urteil zumindest ergänzen. In Deutschland wenig verbreitet sind hingegen digitale Unterstützungssysteme. Breit eingesetzt und untersucht werden diese hingegen in den USA und auch einigen europäischen Ländern (z.B. den Niederlanden). Hier sind die Diskurse deshalb auch weitaus intensiver entfaltet und es werden die beiden letzten Optionen differenziert betrachtet: Weil beispielsweise bei festgelegten Algorithmen die Formel zur Errechnung der Risikosumme aus den gewählten Indikatoren empirisch belegt und gewonnen ist, bleibt oft die Frage, welches Konstrukt die gefundenen Zusammenhäng eigentlich beschreibt. Denn nicht alle Indikatoren, die (in der Regel einmalig) ausgewählt und dann zu einem Algorithmus der Gefährdungseinschätzung zusammengefügt werden, sind sofort für ihre Vorhersagekraft verstehbar.

Die aktuelle Entwicklung mit der Nutzung dynamischer Mustererkennung im Sinne von Predictive Computing spitzen diese Probleme noch zu: Obwohl sich zeigen lässt, dass die Prognosen im Gegensatz zu den vorherigen Verfahren noch einmal besser werden, drängt sich die Frage immer mehr auf, was die KI dann eigentlich „weiß“ im Laufe ihres Lernens an großen und unstrukturierten Datensätzen, entlang derer sie eine Gefährdungsprognose für ein Kind erstellt.

Beobachtet man die Diskurse, lässt sich die Hypothese aufstellen, dass wir Menschen (z.B. den insofern erfahrenen Fachkräften) eher große Anteile impliziten Wissens zutrauen, ohne misstrauisch zu werden, einer KI eher nicht. Hierin dürfte auch der Grund zu suchen sein, dass trotz des Nachweises der Fehlbarkeit klinischer Urteile trotzdem viele Menschen diesen Verfahren trauen.

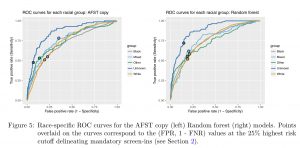

Soziale Arbeit kommt also über den Umweg der Technisierung und Mediatisierung auch hier wieder auf eines ihrer Schlüsselproblem zurück – nämlich wie sich ihr Handeln im Einzelfall und im Gesamtsystem theoretisch und normativ begründen lässt. Bezogen auf die Einschätzung von Chancen und Grenzen von KI-Technologien komme ich hier immer wieder zum gleichen Fazit: Wenn die Vorhersagen und Interventionsmöglichkeiten besser werden (was offensichtlich in vielen, aber nicht allen Anwendungen der Fall ist) und Soziale Arbeit über algorithmisches Lernen noch etwas über sich selbst lernen kann, sollten wir diese Systeme nutzen – und uns selbst und die Technik dabei permanent kritisch reflektieren. In einer Studie von Kolleg*innen aus den USA wurde beispielsweise deutlich, dass auch Vorhersage-Algorithmen klassischen Rassismus zeigen, also Kindeswohlgefährdungseinschätzungen durch KI einen Bias haben, der sich eindeutig nachweisen lässt. Er stammt zum einen logischerweise aus dem Bias derjenigen Fachkräfte, die die Bewertungen für die Lernfälle der KI vorgenommen haben, lässt sich aber andererseits in verschiedenen Algorithmen unterschiedlich nachweisen und berücksichtigen- und damit einem differenztheoretischen Lernen zugänglich machen. Eine KI ist somit auch eine schonungslose Aufklärungsoption über die Fehlbarkeit menschlicher Urteile. Vermutlich wird also die Kombination aus Mensch und Maschine insgesamt die besseren Einschätzungen vornehmen. Auch diese Erkenntnis hat sich schon in der Praxis durchgesetzt, denn in allen innovativen Modellprojekten zum Predictive Computing im Kinderschutz haben letztendlich Fachkräfte und nicht der Computer die alleinige Entscheidungsbefugnis. Letzterer wird aber eben nie müde und lernt stoisch (aber bei der Nutzung von Maschinenlernen eben auch nicht immer sofort nachvollziehbar) hinzu.

Vieles vom hier Gesagten kann man in dieser Paneldiskussion nachvollziehen:

Es diskutieren hier Emily Putnam-Hornstein (Professor at the University of Southern California and Director of the Children’s Data Network), Erin Dalton (Deputy Director, Office of Data Analysis, Research & Evaluation, Allegheny County Department of Human Services), Alexandra Chouldechova (Assistant Professor of Statistics & Public Policy, H. John Heinz III College, Carnegie Mellon University), Moderatorion: Rhema Vaithianathan (Professor of Economics at Auckland University of Technology, Co-Director of the Centre for Social Data Analytics)

Lieber Marc,

danke für den Beitrag. Kann dir in weiten Teilen zustimmen…Mark Schrödter hat das mal in der provokanten Frage aufgeworfen: „Wer macht bessere Diagnosen: der Mensch oder die Maschine?“ mit einem zweideutigem Votum für die non-human actors. 🙂 https://www.researchgate.net/publication/322882954_Wer_macht_bessere_Diagnosen_der_Mensch_oder_die_Maschine

Gleichwohl und daran anschliessend ist dann aber vielmehr die Frage, wie die „Alghorithmen in Aktion“ zu verstehen sind. Wie werden sie eingeführt (aktuarial oder professionell)? Welchen Akteursstatus gewinnen sie (Kollege, Assistenz, Vorgesetzer)? Und wie ist die berufsethische Verantwortung bei geteilten (und mitunter falschen) Entscheidungen zu verstehen? Zu der teils hitzigen Debatte in Amerika („risk assessment wars“) hatte ich mich mal kurz hier geäußert…

https://algorithmenethik.de/2018/01/22/die-algorithmische-kristallkugel-der-us-kinderschutzbehoerden/

lg thomas

Absolut! Was wir zukünftig brauchen, ist eine Praxistheorie, wie künstliche Intelligenzen und menschliche Fachkräfte zusammen arbeiten und wer da welche Agency erzeugt. Das wird ja in anderen Domänen (z.B. in den Ingenieurswissenschaften oder dem Design) schon untersucht. Es liegt halt mal wieder an der Technikferne.

Das mit der „Technikferne“ müssten, sollten wir nochmal ausführlich diskutieren…mir gefällt das als Pauschalurteil irgendwie nicht – nicht dass ich dir das unterstellen will, aber gerade von Digitalisierungs-apologeten wird das mantrahaft in den Raum geworfen…Die Sozialarbeiter können u n d wollen alle nicht, dabei gäbe es doch ein meer an möglicheiten – man müsse nur den computer und das hirn einschalten (denken die schreibtischtäter)…

Ich bin erstmal froh, wenn sich Frontline Social Worker nicht ständig mit Technik rumschlagen, sondern ihre (Interaktions)Arbeit machen…Und die Technikferne ist wenn ja auch bei Politik, Leitung und Wissenschaft gegeben…das problem ist ja vielfach auch: es fehlt die technische infrastruktur, die finanzierung, der freiraum zum ausprobieren, passende bzw. angepasste software die eben fachlichen und nicht manageriellen logiken entspricht….letztlich braucht es ja Gestaltungspartnerschaften von Politik, Praxis, Wissenschaft und Informatik…und wenn das alles dann noch Open Source passiert, dann wäre der fachlichen Entwicklung wirklich geholfen…Aber diese Ideal der Techik ist doch noch relativ fern 😉

Wir müssen das unbedingt ausführlich diskutieren, und eine gescheite Fachtagung wäre auch nicht schlecht. Aber du hast natürlich recht, mein Argument ist nicht nur verkürzt entfaltet. Ich meine weniger die Fachkräfte, die gibt es ja wie überall in medienaffin und medienkritisch. Ich meine die impliziten Logiken Sozialer Arbeit, also dass z.B. für Interaktion immer der kopräsente Kontakt die (heimliche) Referenzfolie ist, obwohl sich z.B. empirisch zeigt, dass das für viele Adressat*innen nicht mehr so ist (und auch kein Defizit bedeutet). Und solange das so ist, werden auch medienaffine Fachkräfte Probleme mit der Digitalisierung haben. Ich hatte neulich eine interessante Diskussion mit ASD-Fachkräften zum Tele-Hausbesuch in Blended-Form (also Präsenz- und Telehausbesuch abwechselnd). Auf die Frage, warum das vehement abgelehnt wird bei gleichzeitiger Begeisterung, mit dem eigenen Kind ständig zu skypen, wurden dann einige nachdenklich. Hoffe, so wird es klarer. Ganz theoretisch aufgeladen könnte ich auch fragen: Ist Soziale Arbeit mit einem heimlichen essenzialistischen Konzept belegt, demgemäß nur kopräsent-körperliche Begegnungen richtige Begegnungen sind?