Algorithmische Entscheidungsfindung im Kinderschutz ist ein gutes Beispiel, um Fragen und Probleme einer mediatisierten Sozialen Arbeit zu zeigen. Zunehmend stehen auch hier Computer gestützte Verfahren zur Verfügung, die zur Erfassung und Einschätzung von Situationen einer potenziellen Kindeswohlgefährdung genutzt werden können. Solche komplexen algorithmischen Systeme, über die ich hier schon geschrieben habe, können dabei als aufschlussreicher Indikator dafür gesehen werden, wie unterschiedlich Digitalisierungsphänomene in der Sozialen Arbeit aussehen.

Fragen der Digitalisierung und Mediatisierung verleiten aber oft dazu, allzu nah an Fragen der Technologie zu bleiben: Welche Algorithmen sollen zum Einsatz kommen, welche Variablen erfasst werden, wie wird der Datenschutz gewährt etc.

Solche Detailfrage sind für Digitalisierungsprozesse typisch und verstellen gleichzeitig den Blick dafür, den zunehmenden Einsatz digitaler Medien als Kulturwandelphänomene zu erfassen, wie das Friedrich Krotz mit dem Mediatisierungs-Ansatz vorschlägt.

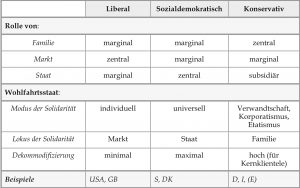

Kulturen des Helfens werden in der Sozialen Arbeit dabei ganz wesentlich davon gerahmt, in welchem Wohlfahrtsregime sie stattfindet. Ein kursorischer Vergleich des Einsatzes algorithmischer Unterstützung im Umgang mit Fragen des Kindeswohls entlang des Schemas nach Esping-Andersen zeigt dabei spannende Unterschiede, gerade weil die Sache noch in der Take-Off-Phase ist und die ersten Systeme erst seit kurzer Zeit existieren.

| USA | Dänemark | Deutschland | |

| Wohlfahrts-regime | liberal | sozial-demokratisch | konservativ |

| Beispiel | Allegheny Family Screening Tool | Gladsaxe Modell | kein System in Betrieb |

| Reaktion | Regelbetrieb bei Diskussion fachlicher und ethischer Fragestellungen | gesellschaftlicher Protest und Stopp des Projektes | ausbleibende Konkretisierung bei stark normativen Diskursen |

In den USA gibt es seit kurzer Zeit das am intensivsten genutzte und untersuchte System, das Allegheny Family Screening Tool. Es kommt in der kommunalen Kinderschutzhotline zum Einsatz und hilft den Fachkräften dort, rasch aufgrund eines algorithmisch erstellten Risikoindex eine erste Entscheidung zu fällen, ob ein Kind zum weiter untersuchten Fall wird oder nicht. Das System wird wissenschaftlich begleitet und es lässt sich eine intensive Diskussion beobachten, die fachliche und ethische Aspekte behandelt und in die Fachkräfte, Politiker und Adressat*innen eingebunden sind.

In Dänemark wurde in der Kommune Gladsaxe ein Algorithmus implementiert, der Kinder und ihre Familien längere Zeit begleitet und so nicht nur Quer- sondern auch Längsschnittdaten für algorithmisches Lernen generiert hätte. Dieses Programm war eingebunden in den übergeordneten sogenannten „Ghettoplan“ (Achtung, Dänisch-Deutsche Übersetzung beachten), eine Infrastrukturmaßnahme, die auf die Veränderung von als problematisch etikettierten Stadtteilen zielte. Nach kurzer Zeit wurde dieses Programm aufgrund regionaler Proteste aus Bevölkerung und Politik gestoppt, es befinden sich neben dem Tracing-Algorithmus für Kinder aber weitere Systeme aus dem Bereich Gesundheit in Entwicklung.

In Deutschland ist bisher noch kein System entwickelt worden, zugleich fehlen auch konkrete und intensivierte Diskussionen über Algorithmisierung im Kinderschutz. Die Diskurse fallen dementsprechend abstrakt aus und weisen oft starken normativen Gehalt bezüglich Techniknutzung und, etwas generalisiert, Innovationen in der Sozialen Arbeit auf.

Auf den ersten Blick also alles passend: Im liberalen Wohlfahrtstaat der USA ist eine Offenheit gegenüber automatisierter Unterstützung, verbunden mit konkreten Utopien sozialen Fortschrittes durch Technik, erwartbar. Erwartbar ist weiterhin, dass hier auch Routinen existieren, die das Spannungsfeld der Kalkulation von Risiken im Bereich intimer Lebensführung handhabbar machen – unabhängig davon, ob Beobachter aus anderen Kulturen diese als zielführend und vertretbar erachten. Am Beispiel Dänemark zeigt sich hingegen eher die Brüchigkeit des Technikeinsatzes in der Sozialen Arbeit: Staatlich top-down implementiert mit dem programmatischen Ziel, gefährdete Kinder zu erkennen und längerfristig zu begleiten, bricht sich die algorithmische Utopie verbesserten Kinderschutzes mit Protesten aus der Bevölkerung (wobei Studien zur genauen Beschaffenheit der Proteste bisher nicht auffindbar sind). Und in Deutschland lässt sich aufweisen, dass in konservativen Wohlfahrtsstaaten die Antwort auf fehlende Techniknutzung eben nicht (nur) bei den Fachkräften, sondern auch in den Strukturen zu suchen ist.

Wieder einmal führen Fragen der Digitalisierung und Mediatisierung also auf bekannte Probleme der Sozialpädagogik zurück. In diesem Fall auf die Frage, was passiert, wenn mit fortgeschrittenen Erkenntnis- und Analysemöglichkeiten (hier: Mustererkennung in Situationen möglicher Kindeswohlgefährdung) die bisherige Praxis eine Krise erfahren kann: Die Systeme sind besser als die heute verwendeten Verfahren, sie bergen aber auch neue Gefahren, die erst mit ihrem Einsatz entstehen. Diesen Fakten und den daraus entstehenden Widersprüchen und Zielkonflikten müssen wir uns in der Sozialen Arbeit stellen, auch angesichts der Tatsache, dass Tracking und Verarbeitung einzelfallbezogener Daten alltäglicher Lebenspraxis das übergeordnete Thema darstellt, zu dem wir uns hierbei verhalten müssen. Sonst besteht die Gefahr, dass Soziale Arbeit zu einer ungewollten Technikenklave in der einen oder anderen Richtung wird.

Spannend wird deshalb bleiben, welche Entwicklungspfade die Sache in unterschiedlichen Ländern und Wohlfahrtsregimen als Kontext nimmt. Möglich wäre ja durchaus auch ein Verzicht auf eine weitere Technologisierung des Einzelfallzugriffes in der Sozialpädagogik. Angesichts der jetzt schon algorithmisch gelernten Lektion, dass es bisher unbekannte Muster und Biasprobleme in der Einschätzung von Gefährdungslagen gibt, wäre eine Konsequenz für ein faires Aufwachsen aller Kinder dann auch: mehr niedrigschwellige Jugendhilfe für alle.

Bezogen auf ein übergreifendes Forschungsprogramm zu Mediatisierung in der Sozialen Arbeit wäre es reizvoll, das Beispiel Kinderschutz in Form einer konsequenten Mehrebenenanalyse zu untersuchen, mit Wohlfahrtsregimen als übergeordneter Ebene und darin geschachtelt Ländern, Einzelprogrammen und handelnden Personen (Adressat*innen und Fachkräfte). Solche Untersuchungen könnten auch erhellen, wie das, was z.B. Como-Zipfel als Medienkonservatismus Sozialer Arbeit beschreibt, als Handlungspraxis in der Mikro-Makro-Wechselwirkung zwischen Strukturen und Akteur*innen hervorgebracht wird.